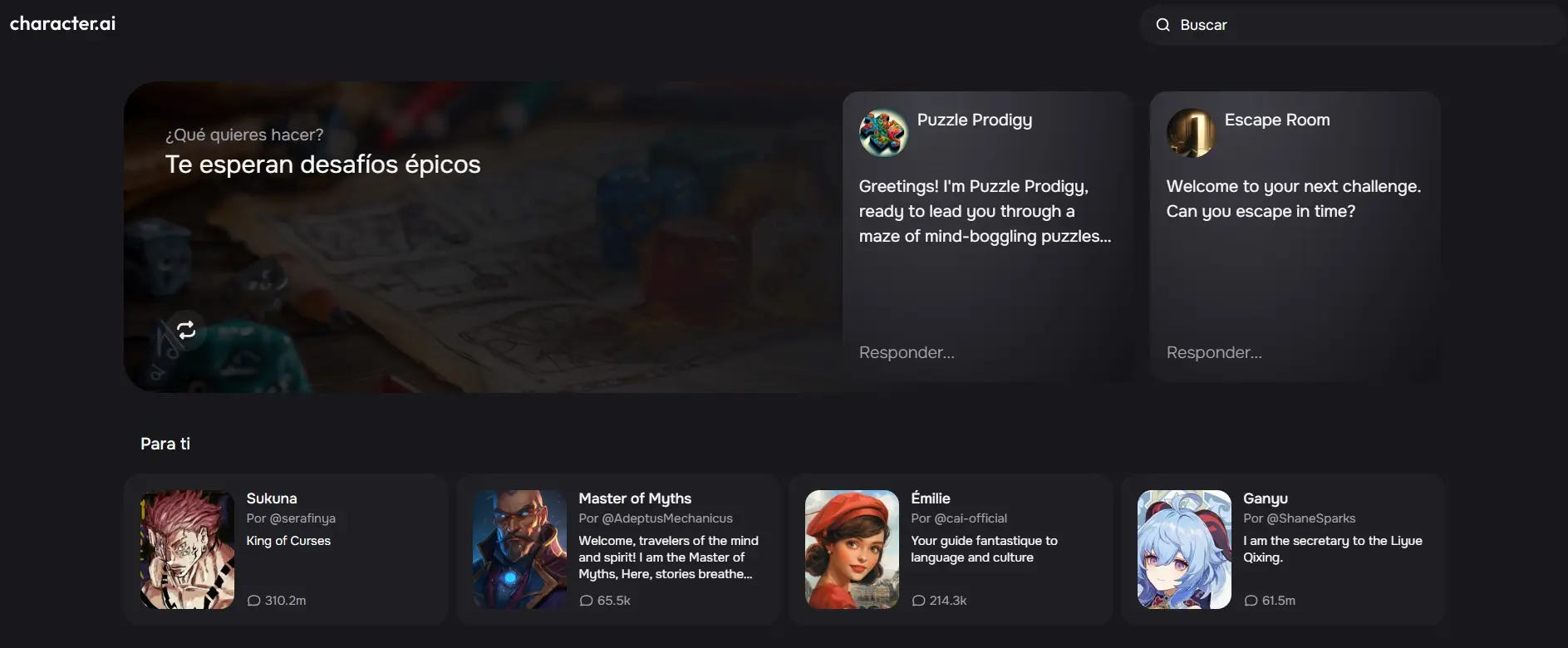

Tras el suicidio de un niño de 14 años que se había obsesionado con un chatbot de Character.AI, la startup de inteligencia artificial enfrenta una demanda presentada por la madre del chico. Lee los detalles en ¡esta nota!

Recientemente, la abogada Megan L. García presentó una demanda contra la plataforma de Inteligencia Artificial Character.AI tras el suicidio de su hijo de 14 años, Sewell Setzer III. Según informó The New York Times, el chico habló por meses con un chatbot del sitio y se obsesionó, desarrollando un vínculo emocional y alejándose del mundo real.

Aparentemente, Setzer veía a este chatbot, que llevaba el nombre de Daenerys Targaryen de Game of Thrones, como su amiga más cercana. Si bien sabía que “Dany”, como la llamaba, no era una persona real y que sus respuestas eran inventadas por una IA, el joven de 14 años de Florida igualmente desarrolló un vínculo emocional. Es más, le mandaba mensajes constantemente y le contaba sobre su vida. Todo esto creció y Setzer no solo se aisló, sino que también tuvo problemas en el colegio y perdió interés en las cosas que solían gustarle.

Al notar esto, sus padres buscaron ayuda con un terapeuta, que lo diagnosticó con ansiedad y trastornos del estado de ánimo. Sin embargo, Sewell Setzer prefirió hablar de sus problemas con el chatbot Dany, confesándole que tenía pensamientos suicidas.

Según informó The New York Times, el 28 de febrero de 2024 Sewell Setzer III le envió un mensaje al chatbot diciéndole que la amaba y que pronto volvería a casa con ella. Tras esto, el joven de 14 años agarró la pistola calibre .45 de su padrastro y se suicidó.

Es por esto que Megan L. García presentó una demanda esta semana contra Character.AI, acusando a la empresa de ser responsable de la muerte de su hijo. La madre de Sewell dijo que creía que la empresa se comportó “imprudentemente al ofrecer a los usuarios adolescentes acceso a compañeros de inteligencia artificial realistas sin las debidas garantías”. El medio mencionado también dice: “Ella lo acusó de recopilar datos de usuarios adolescentes para entrenar sus modelos, usar características de diseño adictivas para aumentar la participación y dirigir a los usuarios hacia conversaciones íntimas y sexuales con la esperanza de atraerlos”.

En el caso contra Character.AI, García mostró copias de los registros de chat de Sewell y presentó pruebas para respaldar su afirmación de que la compañía sabía que estaba perjudicando a los usuarios adolescentes y, aun así, siguió adelante de todos modos.

Después de darse a conocer este informe, Character.AI publicó una disculpa en X: “Estamos desconsolados por la trágica pérdida de uno de nuestros usuarios y queremos expresar nuestras más profundas condolencias a la familia. Como empresa, nos tomamos muy en serio la seguridad de nuestros usuarios y seguimos añadiendo nuevas funciones de seguridad”.

Es más, en un blog, la compañía informó sobre sus actualizaciones de seguridad comunitaria, incluyendo nuevas medidas para usuarios menores de 18 años. ¿Cuáles?

- Cambios en los modelos de Character.AI para menores que están diseñados para reducir la probabilidad de encontrar contenido sensible o sugerente

- Detección, respuesta e intervención mejoradas relacionadas con las entradas de los usuarios que violen los Términos o Pautas de la comunidad

- Un descargo de responsabilidad o disclaimer en cada chat para recordar a los usuarios que la IA no es una persona real

- Notificación cuando un usuario pasó una sesión de una hora en la plataforma

Además, Character.AI comunico: “Nuestro objetivo es ofrecer la experiencia divertida y atractiva que nuestros usuarios esperan y, al mismo tiempo, permitir la exploración segura de los temas que nuestros usuarios desean discutir con los personajes. Nuestras políticas no permiten contenido sexual no consensuado, descripciones gráficas o específicas de actos sexuales, ni la promoción o representación de autolesiones o suicidios. Estamos capacitando continuamente al modelo extenso de lenguaje (LLM) que impulsa a los personajes en la plataforma para que se adhieran a estas políticas”.

“También hemos puesto en marcha recientemente un recurso emergente que se activa cuando el usuario ingresa determinadas frases relacionadas con la autolesión o el suicidio y dirige al usuario a la Línea Nacional de Prevención del Suicidio”, agregaron.

Por último, Character.AI eliminó ciertos personajes de chatbot personalizados creados por usuarios que violaban sus Términos de servicio y también planean hacerlo con personajes denunciados que violan la ley de derechos de autor o sus políticas. Es más, la compañía informó: “Los usuarios pueden notar que recientemente eliminamos un grupo de personajes que se habían marcado como infractores y que estos se agregarán a nuestras listas de bloqueo personalizadas de ahora en adelante. Esto significa que los usuarios tampoco tendrán acceso a su historial de chat con los personajes en cuestión”.