De la mano de la nueva serie Blackwell GeForce RTX 50, NVIDIA abre un nuevo mundo de gráficos por ordenador con IA que ofrece un gran realismo visual y el doble de rendimiento. Todo gracias a la inteligencia artificial, sombreadores neuronales y DLSS 4. Lee todo ¡acá!

La gran feria de tecnología CES 2025 preparó el estadio del hotel Mandalay Bay para la esperada presentación del fundador y director ejecutivo de NVIDIA, Jensen Huang, quien asombró a los más de 13 mil asistentes presentes. En la conferencia, el magnate taiwanés dio a conocer con lujo de detalles las GPU de consumo más avanzadas para jugadores, creadores y desarrolladores: la serie GeForce RTX 50, basadas en la tecnología Blackwell. Pero, además de esto, la compañía anunció un conjunto de tecnologías con IA que viene a revolucionar los gráficos en los juegos.

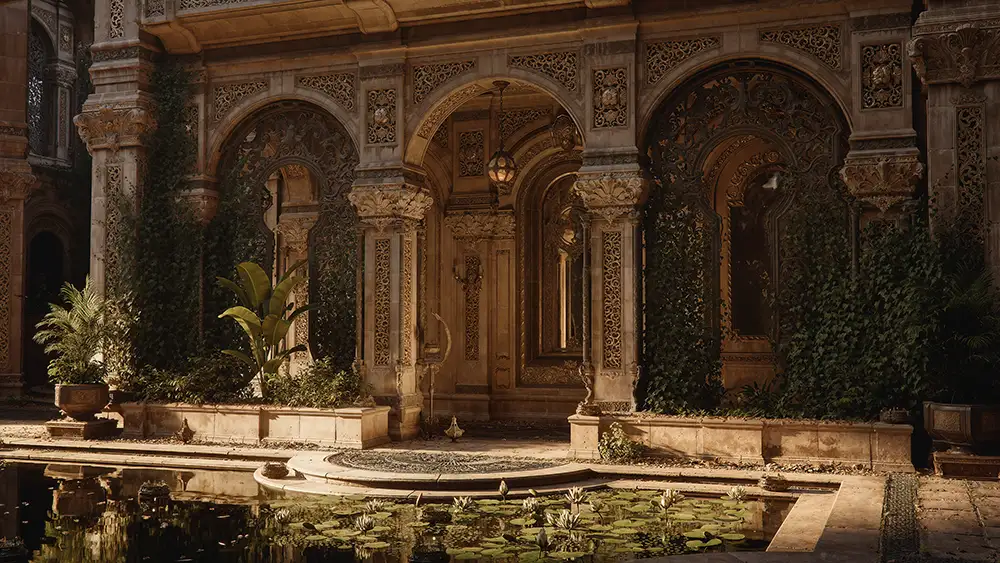

El RTX Kit que presentó NVIDIA en el CES 2025 es un conjunto de tecnologías de renderizado neuronal que no solo traza rayos en juegos con IA, sino que también renderiza escenas con una geometría inmensa y crea personajes con imágenes realistas. De esta manera, el RTX Kit mejora la geometría, las texturas, los materiales y la iluminación, aumentando la fidelidad visual y rendimiento para mundos abiertos complejos.

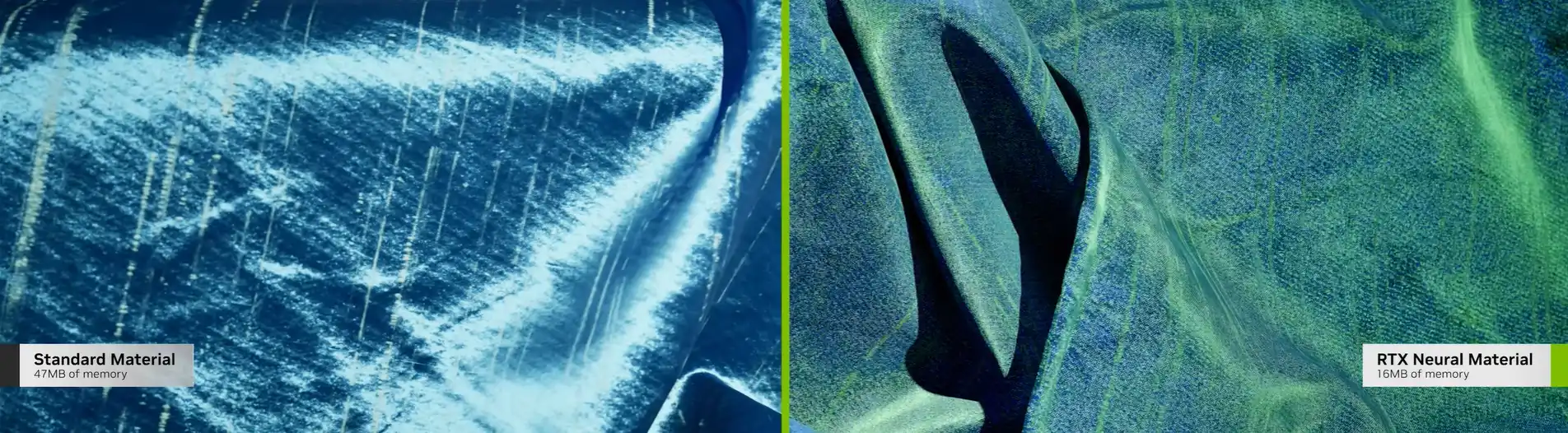

De la mano de esta, NVIDIA presentó RTX Neural Shaders, que incorporan pequeñas redes neuronales de IA a los sombreadores programables, desbloqueando materiales con calidad cinematográfica, iluminación y más en juegos en tiempo real. Las aplicaciones del sombreado neuronal incluyen almacenamiento en caché de radiancia, compresión de texturas, materiales, campos de radiancia y más.

El SDK de los RTX Neural Shaders permite a los desarrolladores entrenar sus datos de juego y código de sombreado en una PC con IA RTX y acelerar sus representaciones neuronales y pesos de modelos con los núcleos tensoriales NVIDIA en tiempo de ejecución. Durante el entrenamiento, estos datos se comparan con el resultado de los datos tradicionales y se refinan a lo largo de varios ciclos.

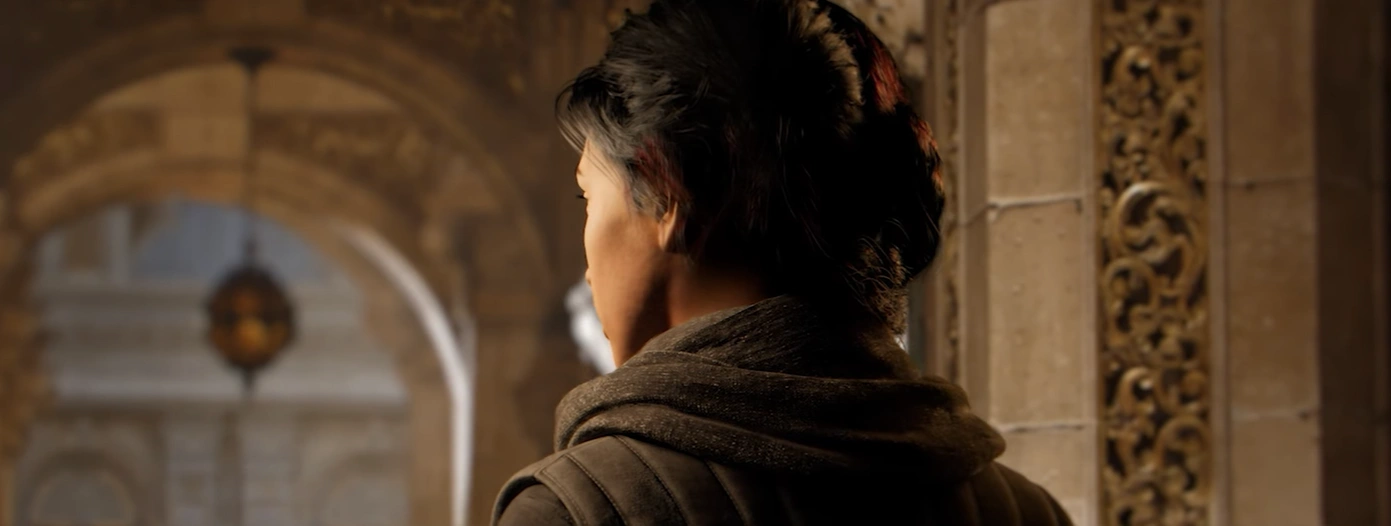

Uno de los elementos más importantes en los juegos es el renderizado de personajes, una de las tareas más complicadas en gráficos en tiempo real, más aun si hablamos de los pequeños detalles en los humanos digitales, donde se notan más lo errores. Y, para dar una mano con esto y facilitar el proceso, NVIDIA presentó RTX Neural Faces. ¿Qué hace? Toma un rostro rasterizado simple y datos de pose 3D como entrada, y usa IA generativa para representar un rostro digital de alta calidad, más natural, y temporalmente estable en tiempo real.

¿Cómo es el proceso de entrenamiento? El rostro generado se entrena a partir de miles de imágenes generadas sin conexión del rostro en cuestión en todos los ángulos, bajo diferentes condiciones de iluminación, emoción y oclusión. Pueden ser fotografías reales o generadas por IA. Luego, el modelo entrenado se optimiza con NVIDIA TensorRT para inferir el rostro en tiempo real.

Según describieron, RTX Neural Faces se complementa con nuevas tecnologías RTX para el pelo y la piel con trazado de rayos. Que estos elementos de los personajes de los videojuegos se vean precisos no es para nada fácil. Es más, las técnicas de vanguardia basadas en mechones de cabello requieren hasta 30 triángulos por mechón y 4 millones de triángulos para un peinado completo.

Para esto, Linear-Swept Spheres (LSS) es una nueva primitiva acelerada por las GPU de la serie GeForce RTX 50 que reduce la cantidad de geometría necesaria para renderizar mechones de pelo y usa esferas en lugar de triángulos para obtener un ajuste más preciso de las formas del cabello. LSS permite hacer cabello con trazado de rayos con un mejor rendimiento y una menor huella de memoria.

Por el lado del renderizado de la piel y cómo interactúa con la luz, NVIDIA habló de la dispersión subsuperficial (SSS), la cual simula cómo la luz penetra debajo de la superficie de los materiales translúcidos y se dispersa internamente, lo que crea una apariencia más suave y natural.

Hasta acá todo bien con los personajes, pero qué pasa con los mundos abiertos y los entornos de los videojuegos. Se sabe que a medida que las escenas de juegos con trazado de rayos aumentan su complejidad geométrica, el costo de construir la jerarquía de volumen delimitador (BVH) de cada cuadro para varios niveles de detalle (LOD) crece. Esto hace imposible lograr velocidades de cuadros en tiempo real. Y acá es donde entra RTX Mega Geometry, que permite hasta 100 veces más triángulos trazados en una escena que el estándar actual.

Entonces, esta nueva RTX Mega Geometry reduce la sobrecarga de la CPU y aumenta el rendimiento y la calidad de imagen en escenas con trazado de rayos, lo que nos lleva a una mejora en el realismo de los personajes y espacios en los videojuegos.

Ahora bien, sabemos que la presencia de inteligencia artificial no es para nada nueva en los videojuegos. Un ejemplo lo vemos en los NPC, que tradicionalmente siguen reglas para adherirse a una historia guiada y brindar una interacción con el jugador. Sin embargo, con el auge de los modelos de lenguaje inteligente, NVIDIA se prepara para que la IA de los juegos tenga una transformación importante con la introducción de los personajes autónomos ACE.

Con tecnología de IA generativa, NVIDIA ACE permite crear mundos de juego dinámicos y vivos con compañeros que comprenden y respaldan los objetivos del jugador, y enemigos que se adaptan dinámicamente a las tácticas del jugador. Para hacer esto posible se utilizan nuevos modelos de lenguaje pequeño (SLM) de ACE capaces de planificar a frecuencias similares a las humanas, necesarias para una toma de decisiones realista, y SLM multimodales para visión y audio que permiten a los personajes de IA escuchar señales de audio y percibir su entorno.

Para replicar la toma de decisiones humana, los personajes del juego deben interactuar de forma natural con los jugadores, percibir su entorno, razonar entre las posibles opciones y planificar y ejecutar estratégicamente su siguiente movimiento en cientos de milisegundos. Las innovadoras técnicas de destilación y los avances en la serie GeForce RTX 50 permiten que varios modelos de IA se ejecuten simultáneamente en una GPU, lo que otorga autonomía a los personajes y maximiza la calidad de la imagen y el rendimiento del juego. Los nuevos modelos NVIDIA ACE que se lanzarán próximamente incluyen Modelos de percepción, modelos para la cognición y modelos de acción.

La percepción, la cognición y las acciones se almacenan en un modelo de integración optimizado que los personajes del juego recuerdan continuamente para tomar su próxima decisión. La implementación de estos modelos dentro de su marco de trabajo de agente impulsará la toma de decisiones similar a la humana en escenarios de juego en tiempo real.

Estos personajes autónomos, que podrán percibir, planificar y actuar como jugadores humanos, se están integrando en PUBG: BATTLEGROUNDS de KRAFTON e InZOI, así como en MIR5 de Wemade Next y NARAKA: BLADEPOINT MOBILE PC VERSION de NetEase.

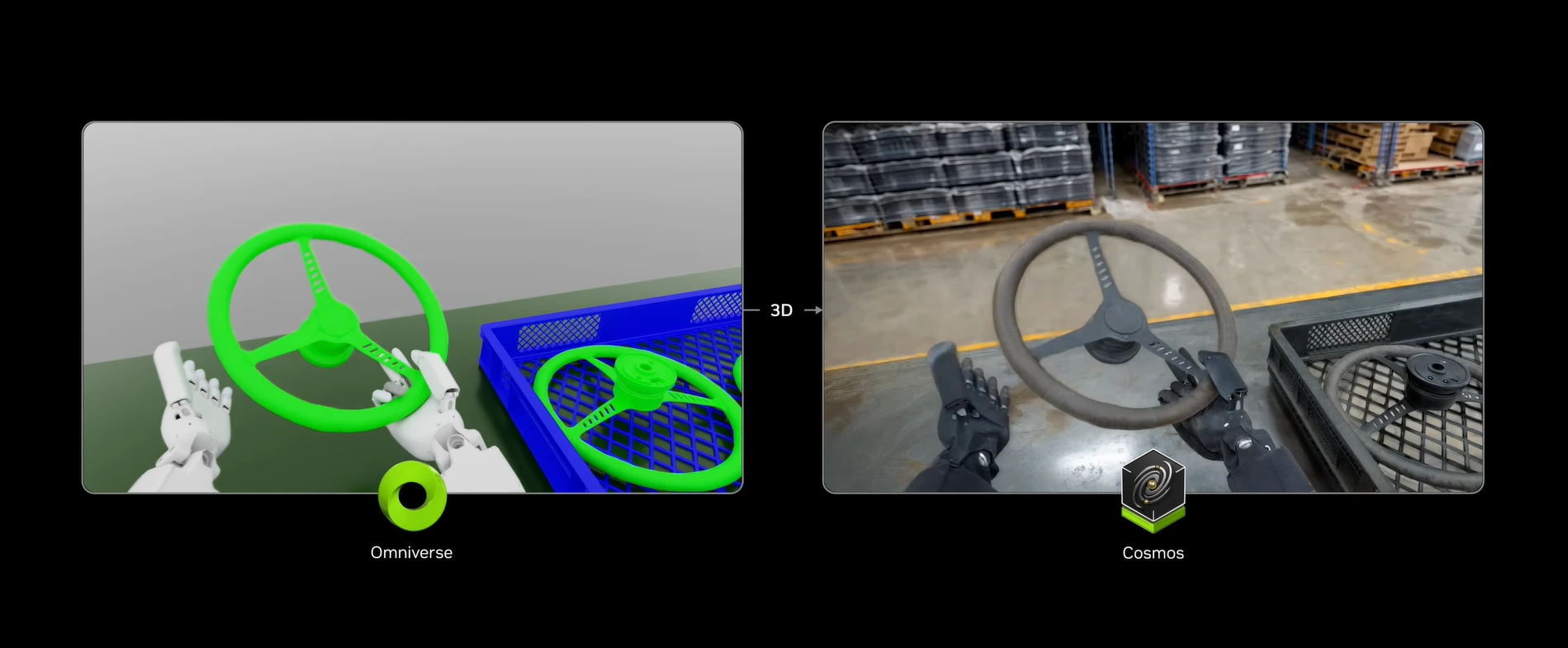

Por otro lado, NVIDIA también maravilló a los presentes en el CES 2025 con otro nuevo modelo de IA generativa: Cosmos, una plataforma diseñada para que la inteligencia artificial vea, entienda y simule el mundo físico real. Este modelo, entrenado en millones de datos del mundo real, acelera el desarrollo de sistemas físicos incorporados en IA, como robots y vehículos autónomos, mediante simulaciones realistas que replican dinámicas físicas.

Según describió la compañía, la integración de Cosmos con NVIDIA Omniverse crea un motor de simulación multiverso y de datos sintéticos de simulación a real para la IA física. “Esto permite generar todos los resultados posibles para un caso de uso determinado, proporcionando a los sistemas físicos de IA la previsión necesaria para tomar decisiones más precisas e informadas”. Sí, puede predecir futuros posibles y tomar acción para acelerar el desarrollo de soluciones avanzadas.

De esta manera, los desarrolladores pueden procesar alrededor de mil objetos 3D en minutos, en vez de estar 40 horas haciendo todo el proceso manualmente, y componer escenarios 3D y renderizar imágenes o vídeos como salidas.

Algunas de las compañías que ya se anotaron para probar Cosmos (un modelo open source) son 1X, Agile Robots, Agility, Figure AI, Foretellix, Fourier, Galbot, Hillbot, IntBot, Neura Robotics, Skild AI, Uber, Virtual Incision, Waabi y XPENG.