OpenAI anunció su nueva versión del modelo de Inteligencia Artificial: GPT-4o, que puede razonar a través de audio, visión y texto en tiempo real. Esta IA llegará tanto a usuarios de ChatGPT gratis como a los de pago en ChatGPT Plus. Lee los detalles en ¡esta nota!

Si bien se pensaba que OpenAI iba a lanzar su propio buscador, la compañía de Inteligencia Artificial sorprendió a más de uno con el anuncio de GPT-4o, su nuevo modelo insignia que integra entradas y salidas de texto, audio e imagen. Básicamente, esta IA puede razonar a través de audio, visión y texto en tiempo real.

Según describieron desde OpenAI, GPT-4o “puede responder a entradas de audio en tan solo 232 milisegundos, con un promedio de 320 milisegundos, que es similar al tiempo de respuesta humano en una conversación”. También iguala el rendimiento de GPT-4 Turbo en texto en inglés y código, con una mejora significativa en texto en idiomas distintos del inglés, a la vez que es mucho más rápido y un 50% más económico en la API. “GPT-4o es especialmente mejor en cuanto a visión y comprensión de audio en comparación con los modelos existentes”, informaron.

Antes de GPT-4o, uno podía usar el modo de voz para hablar con ChatGPT con latencias de 2,8 segundos (en GPT-3.5) y 5,4 segundos (en GPT-4) en promedio. Sin embargo, para lograr esto, se tenía que pasar por tres modelos separados: el primero transcribía audio a texto, el segundo (GPT-3.5 o GPT-4) tomaba el texto y generaba otro, y el tercero lo convertía nuevamente en audio. Todo este proceso hacía que GPT-4 perdiera mucha información: el tono de la voz, ruidos de fondo, risas, emociones o incluso canciones.

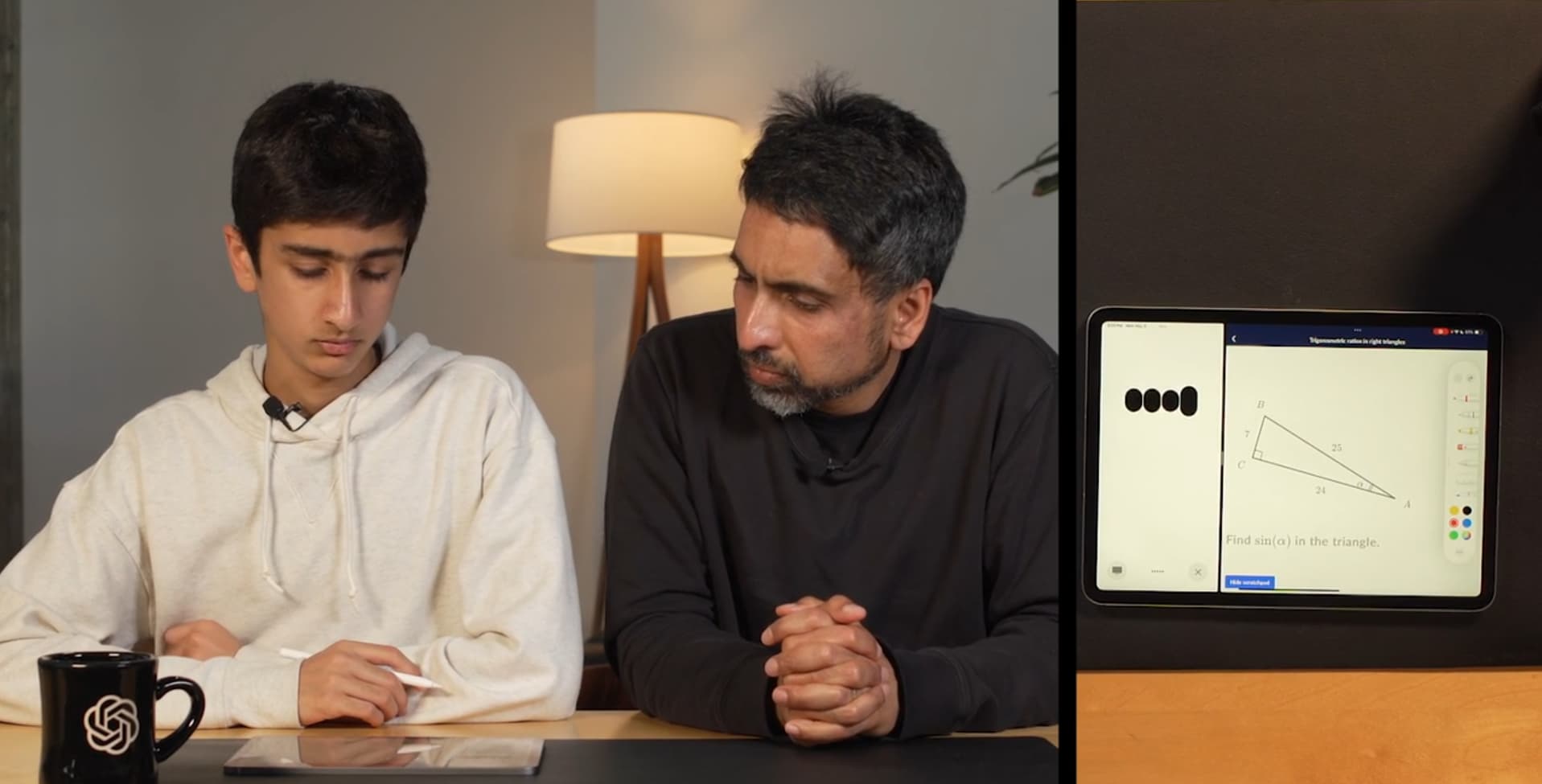

Ahora, GPT-4o será el único modelo de extremo a extremo en texto, visión y audio. Esto significa que todas las entradas y salidas serán procesadas por la misma red neuronal. Pero ¿qué puede hacer y cuáles son sus mejoras?. Desde cantar, reírse, usar sarcasmo y diferentes tonos de voz, hasta leer nuestras expresiones faciales, ver nuestro alrededor, describir escenas visuales y ayudarnos con numerosas situaciones (como problemas de matemática, traducciones, resúmenes de video, texto o audio), entre muchas más interacciones en tiempo real.

Pero esto no es todo. GPT-4o también tiene capacidades avanzadas en procesamiento multimodal, aplicaciones creativas, renderizado 3D, accesibilidad, interacciones de IA a IA, crear personajes, posters, logos e incluso escritura a mano o garabatos surrealistas para documentos personalizados.

Sí, parece que la película Her cada vez se vuelve más real. Este nuevo modelo de Inteligencia Artificial se acercará todavía más a la sensación de estar hablando con una persona de carne y hueso. Para que se den una idea, vamos a poder mostrarle a GPT-4o una comida o una mascota con la cámara y el modelo reaccionará y estará listo para entablar una conversación con nosotros sobre eso.

Actualmente, las capacidades de texto e imagen de GPT-4o están comenzando a implementarse en ChatGPT. Este nuevo modelo estará disponible tanto en el nivel gratuito, como para usuarios de pago, quienes tendrán límites de peticiones hasta 5 veces mayores. También, OpenAI lanzará una nueva versión del Modo de Voz con GPT-4o en alfa dentro de ChatGPT Plus en las próximas semanas.