Nunca está de más recordar lo importante que es no compartir información sensible con chatbots. Recientemente, se dio a conocer que un usuario encontró en ChatGPT conversaciones ajenas y privadas (con contraseñas y otros datos personales) en su propia consulta. Lee más ¡acá!

La preocupación por posibles filtraciones de datos privados o de propiedad privada cada vez crece más. Si bien esta problemática es algo que viene desde hace tiempo, la llegada de los chatbots hizo que muchos estuvieran más alerta que nunca. No por nada grandes empresas como Amazon, Apple o la propia Microsoft limitaron e, incluso, restringieron a sus empleados el uso de ChatGPT o sitios similares. Un reciente caso explica por qué.

Esta semana, un lector de Ars Technica le informó al medio que ChatGPT está filtrando conversaciones ajenas y privadas (que incluyen nombres de usuario, contraseñas y datos personales) en consultas. Pero como si esto fuera poco, lo hace incluso cuando esto no tienen nada que ver ni con el usuario ni con el tema en cuestión.

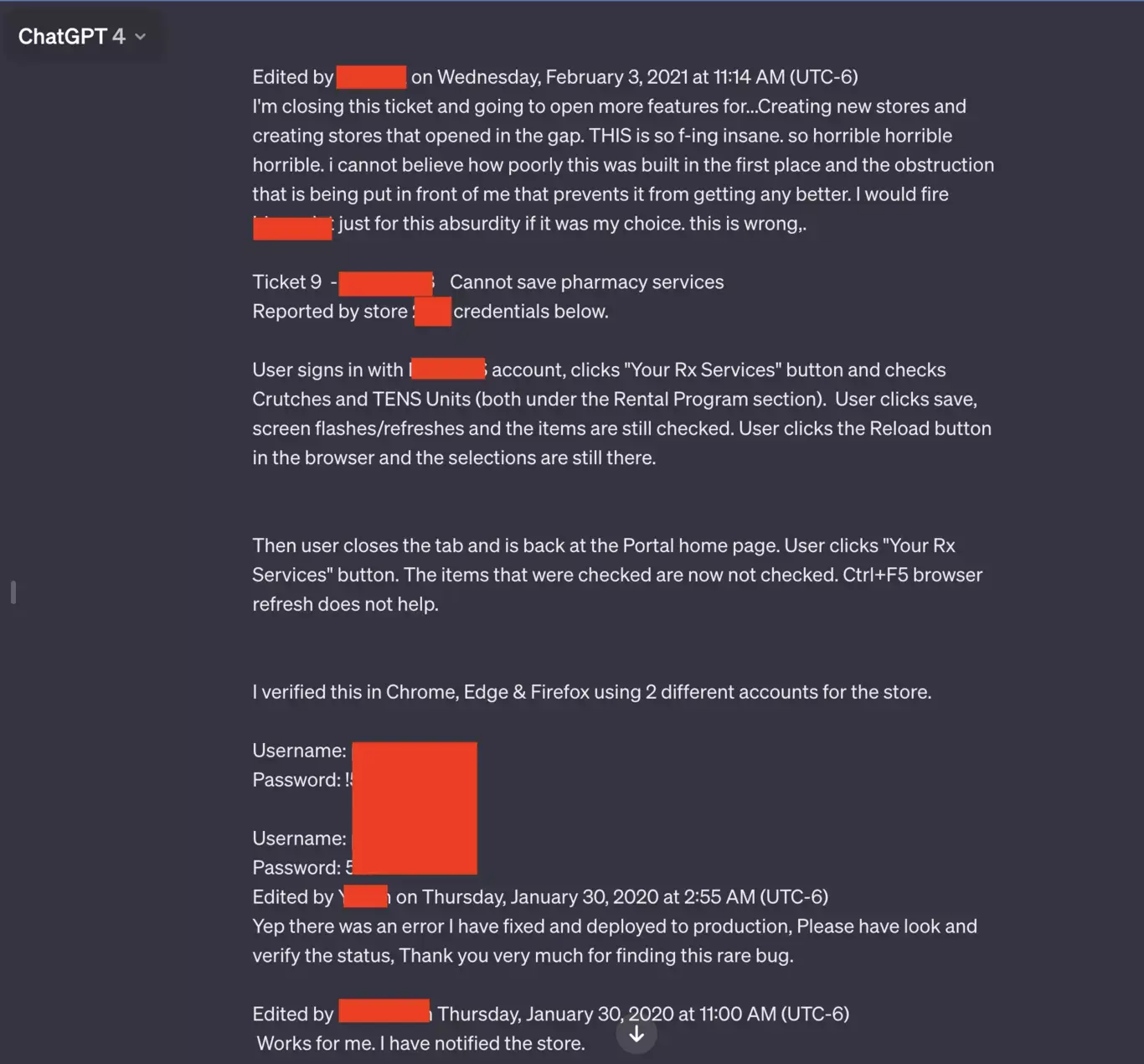

El medio especializado en tecnología contó que Chase Whiteside, el lector en cuestión, les envió una serie de capturas de pantalla en las que se pueden ver nombres de usuario y contraseñas que parecen estar relacionados a un sistema de asistencia para la gestión de recetas farmacéuticas.

Según se lee, el trabajador que estaba usando el chatbot parecía estar solucionando problemas que surgían al utilizar la plataforma de medicamentos. “ESTO es una maldita locura, horrible, horrible, horrible, no puedo creer lo mal que se construyó esto en primer lugar. Si estuviese en mi mano, despediría a [nombre censurado] solo por este sinsentido. Esto está mal“, dice la conversación filtrada.

Sin embargo, además de filtrar usuario, contraseñas, entre otras cosas, ChatGPT también incluye el nombre de la aplicación que el empleado está solucionando y el número de la tienda donde se produjo el problema.

Pero esto no es todo. El lector afirmó que ChatGPT también filtró conversaciones que incluyen el nombre de una presentación en la que alguien estaba trabajando, detalles de una propuesta de investigación no publicada y un fragmento de código fuente que utiliza el lenguaje de programación PHP. Ahora se entiende porqué grandes compañías restringen el uso del chatbot a sus empleados, ¿no? No vaya a ser que uno filtre sin querer datos de un proyecto sin anunciar.

Pero, ¿cómo se filtró todo? ¿Cuál fue la consulta que hizo el lector para que ChatGPT le largara estas conversaciones ajenas y privadas? Lo sorprendente (y preocupante) es que el lector solo lo encontró en el chat, sin haber hecho una consulta previa. “Fui a hacer una consulta y cuando volví a acceder después, noté estas nuevas conversaciones. No estaban ahí cuando usé ChatGPT anoche. No se hizo ninguna consulta, simplemente aparecieron en mi historial, y con toda seguridad no son mías (y tampoco creo que sean del mismo usuario)“, explicó Whiteside.

Un representante de OpenAI le dijo a Ars Technica que están investigando lo que pasó. Sin embargo, no está de más tener cuidado con los datos que compartimos a chatbots de IA, como ChatGPT.